HXLM立磨工艺

FL_HXLM立磨管理经验交流 - 百度文库

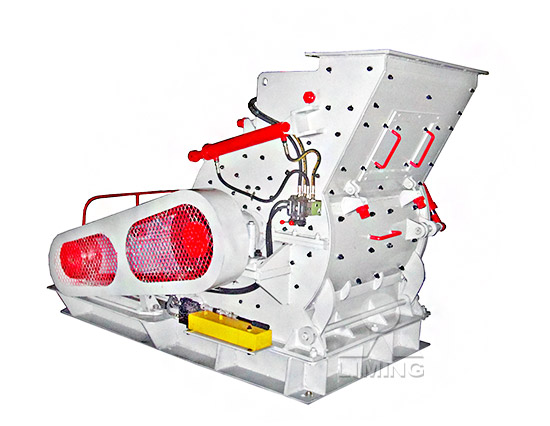

1、磨机进口和出口温度控制的本质意义,是控制磨内物料的干湿程度和产品的含 水量; 2、温度高,料床物料干燥,颗粒之间的摩擦力小,料层难以稳定,磨机难以稳定 运行;温 HLM系列立式磨粉机是桂林鸿程经历二十多年潜心研究开发出的一款集烘干、粉磨、分级、输送为一体的节能的先进粉磨设备。. 桂林鸿程HLM立式磨粉机具有粉磨效率高、电耗低 HLM系列立式磨粉机grm 辊式磨用于水泥原料粉磨,其工作原理是:原料通过二道锁风阀、下料 管落到磨盘中央,横竖旋转着的磨盘借助于离心力的作用将原料向外均匀分散、 铺平,使其形成一定的 立磨原理及操作(详细分析“系统”共32张) - 百度文库

HXLM型立磨安装检查记录.09.06.24 - 百度文库

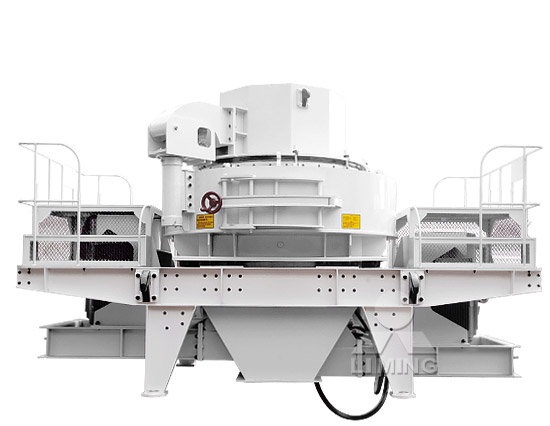

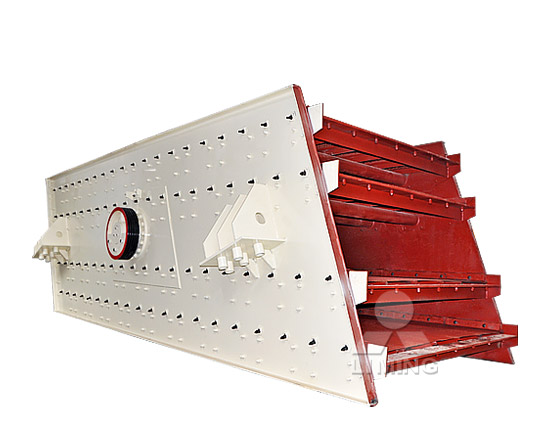

HXLM型立磨安装检查记录.09.06.24. 1、转子锁风叶片与顶部壳体间间隙要尽量的小。. 2、转子叶片内外圆柱面与其内外密封板之间的间隙应尽量均匀偏差不得大于2mm。. 4、在 立磨系统工艺流程简单,布局紧凑,建筑面积小,占地面积约为 球磨机 系统的70%,建筑空间约为球磨系统的60%且可露天布置,直接降低了企业投资费用。且立磨本身有分离器,不需要另加选粉机和提升设备。出磨含尘 立磨 - 百度百科HLM系列立式磨粉机是桂林鸿程经历二十多年潜心研究开发出的一款集破碎、烘干、粉磨、分级、输送为一体的高效节能的先进粉磨设备。 本产品解决了普通工业磨粉机产量低、 HLM立式磨粉机_立式磨粉机_立式磨机_立磨机

HLM立式磨粉机

HLM立式磨粉机是桂林鸿程经历二十多年潜心研究开发出的一款集烘干、粉磨、分级、输送为一体的节能的先进磨粉设备。. 桂林鸿程HLM立式磨粉机具有粉磨效率高、电耗低、入 3.立磨机设备占地面积小、工艺流程简单。 hlm立式磨集细碎、烘干、粉磨、选粉、输送为一体,不需另置烘干、选粉、提升等设备,车间面积仅占球磨系统的70%,空间仅占 立磨,矿渣立磨八大优势_桂林鸿程2023年12月25日 XLM-R 模型作为 Facebook 发布的最新语言模型,因其在多语言机器翻译任务上的出色表现而备受关注。本文将深入解析 XLM-R 模型的架构、原理和应用场景,帮助读者了解 XLM-R 模型的强大之处,以及如何在实际场景中利用 XLM-R 模型解决语言相关的 深度解析:XLM-R模型的神奇之处 - ByteZoneX社区

XLM解读(论文 + PyTorch源码) - CSDN博客

2019年4月25日 文章浏览阅读8.4k次,点赞14次,收藏38次。这篇论文是Facebook在BERT的基础上发展出来的Cross-Lingual版本,即多语的。1. 引入了一个新的无监督方法,用于训练多语的表征,并且提出两个单语的 原文:Unsupervised Cross-lingual Representation Learning at Scale 作者:Alexis Conneau∗ Kartikay Khandelwal∗ 论文发表时间:2020年4月 论文代码: facebookresearch/XLM 一、简介 二、相关工作 三、模型和XLM-R: 大规模无监督跨语言表示模型 - 知乎Unsupervised Machine Translation (UMT) 无监督机器翻译用的比较多的方法是去噪自编码器+循环翻译。具体来说,对于英译德这个任务,搭建起Encoder-Decoder模型之后,可以用英文文本加上噪声,输入Encoder,然后Decoder出一个德文伪数据,再将该德文伪数据输入Encoder,我们希望Decoder输出的是原始的无噪声英文 ...三种Cross-lingual模型 (XLM, XLM-R, mBART)详解 - 腾讯云

facebookresearch/XLM

If you want to play around with the model and its representations, just download the model and take a look at our ipython notebook demo.. Our XLM PyTorch English model is trained on the same data than the pretrained BERT TensorFlow model (Wikipedia + Toronto Book Corpus). Our implementation does not use the next-sentence prediction task and has 火星联盟. Contribute to hxlm/hxlm.github.io development by creating an account on GitHub.hxlm.github.io/index.md at master hxlm/hxlm.github.io2020年7月26日 《原始论文:Unsupervised Cross-lingual Representation Learning at Scale》 Facebook AI团队于2019年11月发布了XLM-RoBERTa,作为其原始XLM-100模型的更新。它们都是基于Transformer的语言模型,都依赖于掩码语言模型目标,并且都能够处理100种不同语言的文本。相较于原始版本,XLM-Roberta的最大更新是训练数据量的显 XLM-RoBERTa: 一种多语言预训练模型 - CSDN博客

Unsupervised Cross-lingual Representation Learning at Scale

Unsupervised Cross-lingual Representation Learning at Scale Alexis Conneau Kartikay Khandelwal Naman Goyal Vishrav Chaudhary Guillaume Wenzek Francisco Guzman´2019年11月5日 This paper shows that pretraining multilingual language models at scale leads to significant performance gains for a wide range of cross-lingual transfer tasks. We train a Transformer-based masked language model on one hundred languages, using more than two terabytes of filtered CommonCrawl data. Our model, dubbed XLM-R, Unsupervised Cross-lingual Representation Learning at ScaleIf you have Telegram, you can view and join HXLM.ORG PROXY-01 right away. right away.Telegram: Contact @hxlm2

FacebookAI/xlm-roberta-large Hugging Face

XLM-RoBERTa (large-sized model) XLM-RoBERTa model pre-trained on 2.5TB of filtered CommonCrawl data containing 100 languages. It was introduced in the paper Unsupervised Cross-lingual Representation Learning at Scale by Conneau et al. and first released in this repository.. Disclaimer: The team releasing XLM-RoBERTa did not write a model card for 2019年11月29日 本文的XLM-R(XLM-RoBERTa)证明了使用大规模多语言预训练的模型可以显著提高跨语言迁移任务的性能。XLM-R在技术上等同于XLM+RoBERTa,在数据上使用100种语言、2.5TB文本数(CommonCrawl项目爬取的)进行训练。Facebook 提出一种新型BERT:面向跨语言理解的XLM-ROverview. The XLM-RoBERTa model was proposed in Unsupervised Cross-lingual Representation Learning at Scale by Alexis Conneau, Kartikay Khandelwal, Naman Goyal, Vishrav Chaudhary, Guillaume Wenzek, Francisco Guzmán, Edouard Grave, Myle Ott, Luke Zettlemoyer and Veselin Stoyanov. It is based on Facebook’s RoBERTa model released XLM-RoBERTa - Hugging Face

XLM-Roberta-Large-ViT-H-14__frozen_laion5b_s13b_b90k

Model Description This repo contains ONNX exports for the corresponding ViT-based multilingual CLIP model by OpenCLIP. See the OpenCLIP repo for more info. Visual and textual encoders are separated into separate models for the purpose of generating image and text embeddings.2023年12月12日 Type Model Date Download Note; Vision-Language Foundation Model: InternViT-6B-224px: 2023.12.22: 🤗 HF link: vision foundation model: InternVL-14B-224px: 2023.12.22: 🤗 HF link: vision-language foundation model, InternViT-6B + QLLaMA, can be used for image-text retrieval like CLIPInternVL: Scaling up Vision Foundation Models and Aligning for HM is your shopping destination for fashion, home, beauty, kids' clothes and more. Browse the latest collections and find quality pieces at affordable prices.HM Online Fashion, Homeware Kids Clothes HM US

[1901.07291] Cross-lingual Language Model Pretraining - arXiv

2019年1月22日 Recent studies have demonstrated the efficiency of generative pretraining for English natural language understanding. In this work, we extend this approach to multiple languages and show the effectiveness of cross-lingual pretraining. We propose two methods to learn cross-lingual language models (XLMs): one unsupervised that only 2023年5月9日 文章浏览阅读649次。最近的研究证明了生成式预训练对英语自然语言理解的有效性。在这项工作中,我们将这种方法扩展到多种语言,并展示了跨语言预训练的有效性。我们提出了两种学习跨语言语言模型 (xlm) 的方法:一种是仅依赖单语言数据的无监督方法,另一种是利用具有新的跨语言语言模型 ...论文阅读【自然语言处理-预训练模型】XML:Crosslingual ...